Tekoälyn ja laskentatehon nopea kehitys on käynnistänyt kilpavarustelun, joka muuttaa sodankäynnin luonnetta ja asettaa haasteita kansainväliselle sopimusjärjestelmälle. Oli loppupäätös voimankäytöstä ihmisellä tai koneella, tälläkin teknologisella kilpavarustelulla vaikuttaisi olevan tuttu seuraus: sotilasvoimien tuhopotentiaalin merkittävä kasvu.

Infopaperin tilaajana toimii kansainvälisen Stop Killer Robots -kampanjan Suomen verkosto (Stop Killer Robots Finland), jonka toimintaa kampanja tukee rahallisesti. Stop Killer Robots edustaa yli 70 maassa yli 250 kansalaisyhteiskunnan organisaatiota, jotka työskentelevät autonomisia asejärjestelmiä koskevan kansainvälisen lain luomiseksi. Verkostossa toimii

suomalaisia rauhanjärjestöjä, tutkijoita ja yksittäisiä aktiiveja.

Tämä infopaperi tarkastelee autonomisten aseiden määritelmää ja tekoälypohjaista sodankäyntiä, niiden merkitystä strategisessa kilpailuasetelmassa, sekä kansainvälisen asevalvonnan kohtaamia vaikeuksia nopeasti kehittyvien teknologioiden kohdalla.

Autonomiset asejärjestelmät ovat tekoälypohjaisia järjestelmiä, jotka keräävät tietoa ympäristöstään sensoreiden avulla ja tekevät itsenäisiä päätöksiä aseellisista toimista algoritmien perusteella, vähäisellä ihmisen ohjauksella tai täysin ilman sitä.

Ihmiskontrollin määrittelyn haasteet: Keskustelua herättää se, kuinka vähäinen ihmisen roolin tulee olla, jotta järjestelmä luokitellaan autonomiseksi eli itseohjautuvaksi. Inhimillisen kontrollin ylläpitämistä on pidetty keskeisen tärkeänä. Roolin eri asteiden vuoksi olisi kuitenkin yhtä lailla syytä puhua autonomisista aseista, puoliautonomisista aseista ja ylipäänsä tekoälyvahvistetusta sodankäynnistä.

Autonomiset aseet ovat nyt erityisen kiinnostavia, sillä niiden käyttö sodankäynnissä yleistyy nopeasti, erityisesti suurvaltojen kuten Yhdysvaltojen ja Kiinan kilpavarustelun myötä. Tekoälyn käyttö lisää aseiden nopeutta, tarkkuutta ja kustannustehokkuutta ratkaisevasti, mikä tekee siitä strategisesti merkittävän kehityskohteen nykyisessä sotilaallisessa kilpailuasetelmassa.

Haasteet asevalvonnalle: Kansainvälinen asevalvonta kohtaa haasteita tekoälypohjaisten aseiden haitallisen leviämisen estämisessä, koska tekoäly on immateriaalista ja helposti kopioitavaa. Siksi nykyiset valvontatoimet ovat keskittyneet lähinnä laskentatehon rajoittamiseen. Nopeasti kehittyvät teknologiat haastavat perinteisiä sääntelymekanismeja, ja asevalvonnan kehittäminen onkin tarpeen.

Tekoälyvahvistettujen aseiden haitallisen leviämisen hillitseminen edellyttää uusia sääntelykehityksiä, jotka huomioivat tekoälyn erityiset riskit ja kertautuvat vaikutukset eri aseteknologioiden kanssa. Vientivalvonta, datan hallinnan sääntely, aseteknologian sijoittajien sekä ostajien käytänteet sekä eri toimitusketjun vaiheita hallitsevat monopolistiset yritykset voivat olla keskeisiä haitallisen leviämisen rajoittamisessa. Vaikeasti määriteltävä rajanveto autonomian kohdalla vaatii myös sodankäynnin sääntöjen päivittämistä ja niiden valvontaa.

Center for Arms Control and Non-Proliferationin määritelmän mukaan autonomiset asejärjestelmät (AWS) keräävät ympäristöstään tai toimintakentästään dataa sensorien tai muiden tietolähteiden avulla ja päättävät toimintatavan algoritmien ja tekoälyn antaman datan pohjalta, minkä seurauksena ne toteuttavat aseellisia toimia tavoitteen saavuttamiseksi joko itsenäisesti tai vähäisen ihmiskontaktin kanssa.[1]

Keskeisin kansainvälistä sääntelykeskustelua leimaava määritelmäkiista on se, kuinka vähäinen ihmisen roolin tulee olla, jotta kyseessä on AWS-järjestelmä. Useimpiin määritelmiin sisältyy eri autonomian asteita itseoppimisesta ja toiminnasta. Täydestä itsenäisyydestäkään ei ole yksimielisyyttä. Saksa sisältää määritelmäänsä jopa ”tietoisuuden”, mitä useimmat tutkijat pitävät vasta kaukaisen tulevaisuuden ominaisuutena, ellei mahdottomana.[2]

Vaatimukset täydellisistä määritelmistä ja kuvitelmat tietoisesta tekoälystä eivät kuitenkaan saisi hämärtää ymmärrystä siitä, että viimeisimmät vuodet ovat jo merkinneet kiihtyvää kehitystä ja huomattavia askelia kohti AWS-kaltaisten järjestelmien käytännön yleistymistä taistelukentillä. Tämä infopaperi käsitteleetekoälyvahvistetun aseteknologian kilpavarustelua yleisluontoisesti, keskustellen autonomisista asejärjestelmistä tekoälyjärjestelmän ”kehittyneimpänä asteena”.

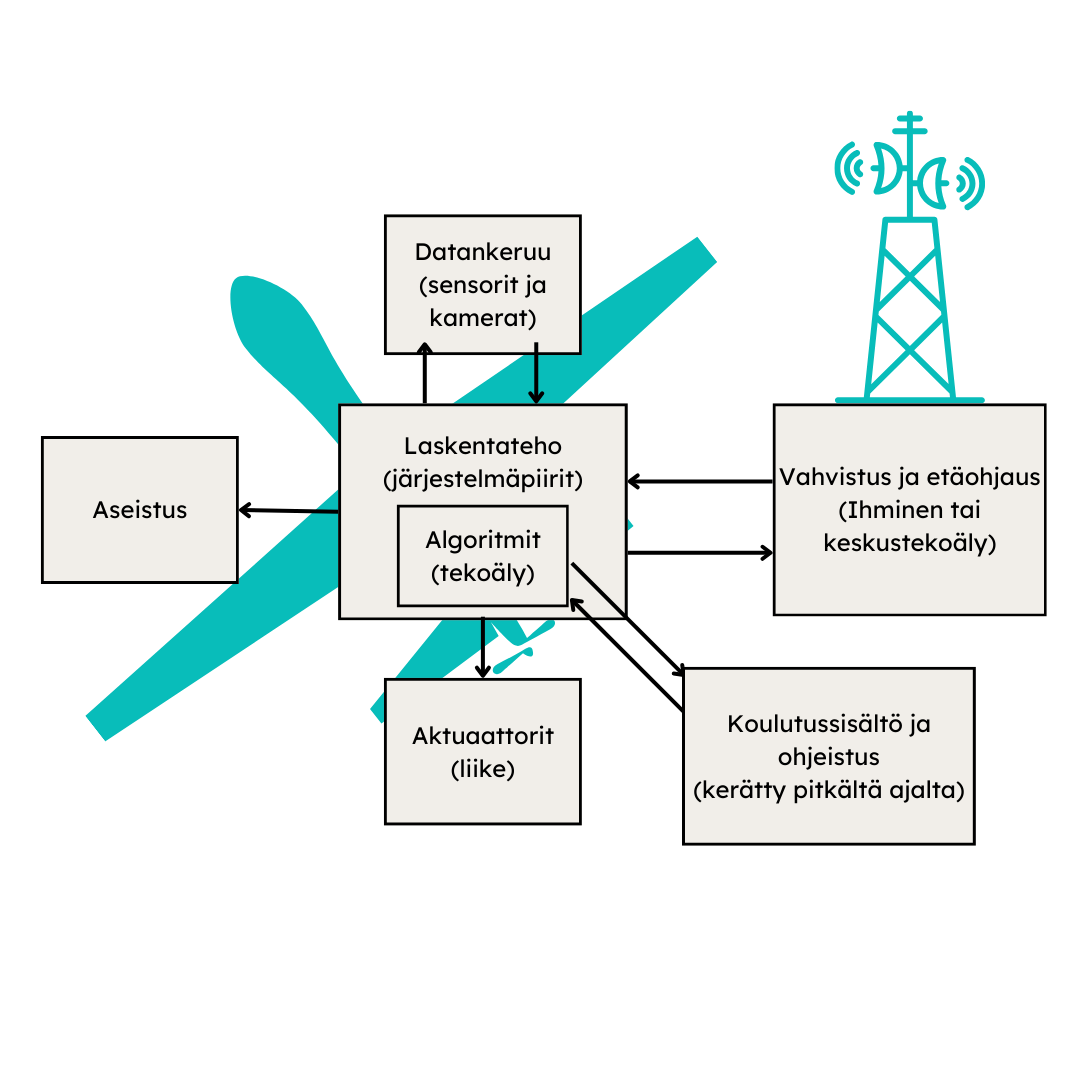

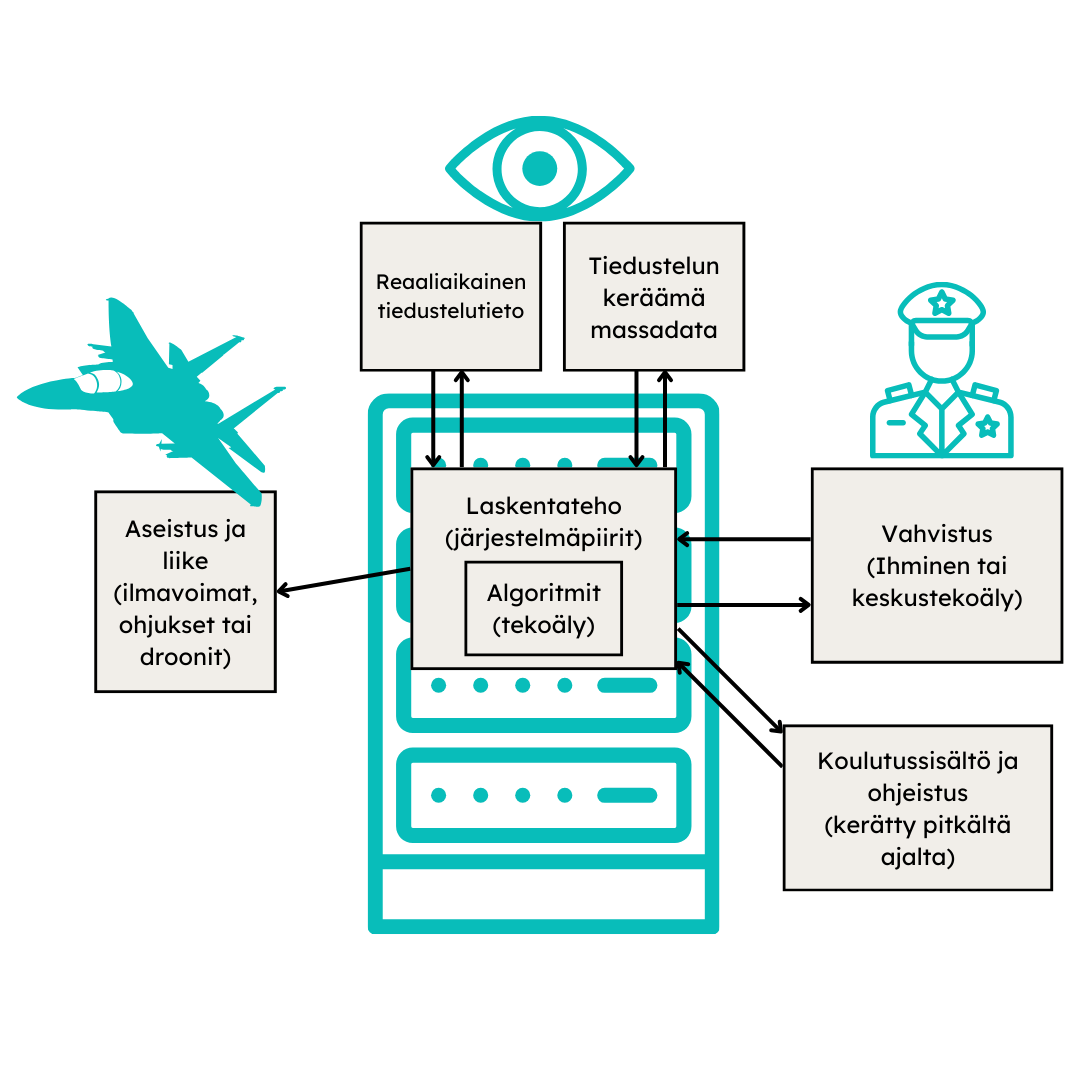

Yleiskielen tekoäly-sanalla tarkoitetaan yleisimmin koneoppimisjärjestelmiä. Ne toimivat käyttämällä laskentatehoa(1) datasta oppivien(2) algoritmien suorittamiseen(3)”. Center for Security and Emerging Technologyn Ben Buchananin mukaan tähän ”tekoälytriadiin” kiteytyy kaikki oleellinen, joka päättäjän tulee tekoälystä tietää.[3] Viime aikoina puhuttanut tekoälyn kehitys on siis suora seuraus näiden kolmen teknologian yhtä aikaa tapahtuvista kehitysaskelista.

Tekoälypohjainen järjestelmä syntyy, kun kamerat tai sensorit, liikkumisen mahdollistavat aktuaattorit ja tietokoneohjattavat aseet yhdistetään koko järjestelmää tekoälyllä ohjaavaan tietokoneeseen. Aseita ja sotilastarkoitukseen kehitettyjä algoritmeja lukuun ottamatta jokainen näistä teknologioista on kaksikäyttöinen.

Seuraava yksinkertaistettu kaavio kuvaa kahta erilaista tekoälyn sotilaallista käyttötapaa: autonomisesti ohjautuvaa lennokkia eli droonia (1) ja tekoälyä kohteiden tunnistamiseen hyödyntävää järjestelmää (2), joiden toimintaperiaate on järjestelmän osien eroista huolimatta huomattavan samanlainen. Kaavion kaltaiset lennokit ovat vuoteen 2024 mennessä olleet jo yleisesti sotakäytössä ainakin Ukrainalla, Turkilla ja Yhdysvalloilla.[4] Esimerkkejä jälkimmäisestä järjestelmästä taas ovat Palantirin Ukrainassa testaama satelliittidataan perustuva tykistöä kohdentava järjestelmä, sekä Israelin asevoimien (IDF) sisäisten vuotojen mukaan Israelin Gazassa käyttämät, todennäköisyyslaskentaan perustuvat Habsora– ja Lavender -järjestelmät.[5]

Vaikka on epäselvää miten ratkaisevaa etua tekoäly tuo taistelukentällä, usko mullistavaan vaikutukseen on laajasti jaettua. Yhdysvaltain armeijan vastavoimastrategiat (Offset Strategy) ovat kylmän sodan alusta lähtien perustuneet määrällisen ylivoiman voittamiseen laadullisella etumatkalla. Siinä missä ensimmäinen vastavoimastrategia asetti ydinpelotteen keskiöön ja toinen perustui Persianlahden sodassa selkeimmin nähtyyn teknologiseen etumatkaan ja äärimmäiseen tarkkuuteen, kolmas kehitetty strategia perustuu erityisesti tekoälyn tuomaan kvalitatiiviseen ylivoimaan, joka nähdään ainoaksi keinoksi voittaa uudessa suurvaltakilpailussa.[6]

Samaan aikaan myös Kiinan kansan vapautusarmeija (PLA) tavoittelee asevoimien täyttä modernisaatiota tekoälyn avulla vuoteen 2035 mennessä.[7] Teknologisissa prioriteeteissä toistuvat käsitteet kuten koneoppiminen, kyberhyökkäykset sekä yhdessä kaikenkattavassa komento-, hallinta-, viestintä- ja tiedusteluverkossa ihmisten kanssa toimivat autonomiset aseet.[8]

Edullisuus ja uhrattavuus

Keskeiseksi eduksi autonomisissa ja tekoälypohjaisissa asejärjestelmissä katsotaan mm. miehittämättömien lennokkien (UAV, nk. droonit) kohdalla edullisuus ja uhrattavuus (attritability) verrattuna ihmissotilaisiin ja heidän ohjaamiin sotilaskoneisiin. Uhrattavuus mahdollistaa massiivisen mittaluokan käytön, jonka torjuminen käy suhteessa kalliiksi eikä aiheuta hyökkääjälle ihmisuhreja.

Esimerkiksi Pentagonin vuoden 2023 syksyllä paljastama Replicator-hanke pyrkii vastaamaan Kiinan määrälliseen etuun ottamalla kahden vuoden sisällä eri aselajeissa käyttöön tuhansia autonomisia, pieniä ja edullisia lennokkeja.[9] Kehitys on pitkällä myös maan ilmavoimissa, jossa tekoälyjärjestelmiä on koulutettu ohjaamaan hävittäjiä tehtävissä, jotka ovat ihmisille liian vaarallisia, riskialttiita ja jopa fysikaalisesti mahdottomia.[10]

Nopeus, tarkkuus ja kattavuus

Sodankäynnissä oleellista on myös reaktioaika ja nopeus, missä tietokoneiden nykyistä gigahertsien laskentatehoa ihminen ei voi millään päihittää. Taistelutilanteissa kyse voi olla parhaimmillaan millisekunnista, jolloin pienikin nopeusero mikropiireissä voi ratkaista, eikä kannusta pitkään harkinta-aikaan.

Yhdysvaltain asetekoälyn lippulaivaprojekti Project Mavenin koneoppimisalgoritmien kerrotaan tunnistaneen mittavan ilmakuvadatan avulla kohteita jopa 85 ilmaiskuun Irakissa, Syyriassa, Jemenissä ja Punaisellamerellä vuoden 2024 helmikuun aikana.[11] Israelin asevoimien sisäpiirilähteiden mukaan Lavender-järjestelmä taas kykeni 2,3 miljoonasta gazalaisesta kerätyn tiedustelutiedon pohjalta merkitsemään jopa kymmeniä tuhansia ihmisiä potentiaalisiksi viholliskohteiksi.[12]

Ihmisen roolin pieneneminen

Tekoälyn kehityksen synnyttämä kilpailu nopeudesta ja sotatoimien muuttuminen edullisemmiksi ja helpommiksi kannustaa vähentämään ihmisen roolia ja toteuttamaan sotatoimia yhä laajemmassa mittakaavassa, kun myös ihmisuhrien riski hyökkääjän puolella vähenee, ja suhde varsinaiseen taisteluun ja kuolemaan etääntyy ja jopa pelillistyy.[13]

Kerätyn datan ja kohteiden määrä voi myös johtaa siihen, että puoliautonominen tekoäly on ihmisen hallinnassa käytännössä vain periaatteen tasolla; esimerkiksi IDF:n henkilöstön väitetään priorisoineen eliminoitujen kohteiden määrää ja käyttäneen keskimäärin vain 20 sekuntia kunkin kohteen vahvistamiseksi – ja luottaneen enemmän ”rationaaliseen koneeseen” kuin ”ailahtelevan ihmisen arvioon”. Tämä olisi selkeä muutos aiempien vuosien prosessiin, jossa yksittäisten salamurhakohteiden vahvistaminen tehtiin pitkän ja monimutkaisen prosessin kautta, ja vuosittainen tunnistettujen kohteiden määrä laskettiin kymmenissä.[14] Tilanne, jossa ihminen alkaa luottaa lähtökohtaisesti aina ensisijaisesti koneeseen itsensä sijaan on yleinen kaikissa hyvin automatisoiduissa työympäristöissä. Sitä kutsutaan automaatiovinoumaksi.

Eräs nouseva kysymys on: voiko nopeuden, laajuuden ja kattavuuden mahdollistama tavanomaistenkin aseiden tuhopotentiaalin kasvua pitää uudenlaisena joukkotuhoaseena, oli kyse ”kirurgisen tarkoista” maanlaajuisista kertakohdennuksista tai lennokkiparvista.[15] Oli uhka laajuudessa tai nopeuden tuomassa edussa taistelutilanteisiin, kannustimet ovat kunnossa kilpavarusteluun – mitä pidetään jopa moraalisena velvollisuutena, perustellen tekoälyn mahdollistamalla tarkkuudella, joka voisi johtaa myös vähempiin sivullisiin uhreihin.[16]

Henry Kissinger & Graham Allison muistuttivat vuonna 2023, että jopa kiihkeimmän ydinasevarustelun aikana Yhdysvallat ja Neuvostoliitto löysivät yhteisiä intressejä ydinteknologian leviämisen rajoittamisesta ja täysimittaisen ydinsodan estämisestä, mm. sallimalla epävirallisesti toisilleen toistensa alueiden valvonnan ja rajoittamalla ohjuspuolustusta vuoden 1972 ABMT-sopimuksella. Samaan aikaan he kuitenkin totesivat, ettei suurvalta ole kilpailijan kehittämän teknologian aiheuttaman eksistentiaalisen turvallisuusuhan edessä jättänyt itse kehittämättä kyseistä teknologiaa kertaakaan historiassa.[17]

Tekoälyjärjestelmän kehitys vaatii kehitystä kaikissa kolmessa ”tekoälytriadin” pilarissa. Sen jälkeen, kun GPU-pohjainen rinnakkaislaskenta osoittautui neuroverkkojen suorittamisessa ylivoimaiseksi perinteisiin CPU:ihin nähden, on laskentateho ottanut huimia loikkia erityisesti datakeskussuorittimia suunnittelevan yhdysvaltalaisen NVIDIA:n johdolla. Koska laskentateho – fyysiset suorittimet – on triadin ainoa materiaalinen pilari, on nopeimpien GPU-suorittimien vientivalvonnasta tullut 2020-luvulla Kiinan ja Yhdysvaltain taloudellisen ja sotilaallisen tekoälykilpailun keskeisin polttopiste.[18]

Samaan aikaan kansainvälisen sopimusjärjestelmän syntyä on rajoittanut puhtaan laskentateknologian täysi yleiskäyttöisyys ja markkinoiden keskittyneisyys muutamaan valtioon. Kehittyneimpien tekoälysirujen valmistusketjun kutakin osaa hallitsevat lähes monopolistiset yritykset: suunnittelua NVIDIA (Yhdysvallat), valmistukseen vaadittavia EUV-litografian laitteita ASML (Alankomaat) ja sirujen valmistusta TSMC (Taiwan).[19]

Jossain yleiskäytön ja sotilaskäytön puolivälissä sijaitsee data. Internetin sisältämän avoimen digitaalisen informaation eksponentiaalinen kasvu on mahdollistanut ChatGPT:n tapaisten kielimallien nykyisen kehitystason. Samoin erityisesti Venäjän vuonna 2022 aloittaman hyökkäyksen jälkeen Ukrainan sodasta kerätyn videosisällön, ilmakuvien ja käytännön taisteludatan valtaisa määrä on erinomaista polttoainetta sotilaskäyttöisten koneoppimisalgoritmien koulutukselle ja kehitykselle, kuten myös Israelin kahdesta miljoonasta gazalaisesta väitetysti keräämä tiedustelutieto.

Ukrainalaisen drooneja ja taistelutekoälyä kehittävän Aerorozvidka-järjestön mukaan Ukraina ”toteuttaa jo nyt täysin robotisoituja sotilasoperaatioita, ilman ihmisen interventiota”.[20] Persianlahden ja Hormuzinsalmen valvonta on myös toiminut koekenttänä, jossa miehittämätön yhdysvaltalainen laiva toteutti lokakuussa 2023 ensi kertaa onnistuneen ohjusiskuharjoituksen ilman ihmisen taktista ohjausta.[21]

Datan omistajuuteen ja keräämiseen liittyvä sääntelykehikko on täysin oma lukunsa, mutta sitä analysoivia ase- ja kaksikäyttöisiä algoritmeja ja sovelluksia on jonkin verran pyritty jo rajoittamaan. Ensimmäinen Yhdysvaltain uuden vientivalvontalain pohjalta nousevalle teknologialle, vuonna 2020 asetettu rajoitus, koskikin juuri satelliittidataa analysoivan tekoälysovelluksen myyntiä ulkomaille.[22]

Esitettyä uutta kansainvälistä monenkeskistä ja konsensuspohjaista vientivalvontajärjestelmää ei ole edes yleiskäyttöisen tekoälyn kohdalla kuitenkaan vielä onnistuttu luomaan. Sen sijaan pinnan alla kytevästä kilpavarustelukierteestä kertoo se, miten Yhdysvallat on alkanut kiihtyvään tahtiin soveltaa yksipuolisia rajoituksia keskeisimpien valtioiden kanssa nopeimpien piirilevyjen vientiin erityisesti Kiinaan ja Venäjälle, akuutteihin kansallisen turvallisuuden huoliin vedoten.[23]

Sopimusvalvonnan kannalta keskeisin ero ydinteknologiaan on kuitenkin se, että juuri sotilaskäyttöinen tekoäly on täysin digitaalista, puhtaasti immateriaalista tietopääomaa. Ihmisen tunnistamiseen ja tappamiseen kykeneviä tekoälyjä pidetään paljon helpommin kehitettävänä kuin vaikka itseajavia autoja, yksinkertaisuudeltaan jopa ”opiskelijaprojektin tasoisina”, joita on helppo kopioida tai varastaa minne päin maailmaa tahansa.[24]

Myös Israelin puolustusvoimat vastineessaan Lavender-paljastuksiin perusteli, että käytössä ei ole yksittäistä tekoälyjärjestelmää, vaan tiedustelulähteitä yhdistävä tietokanta, jota analysoidaan erillisillä analytiikkasovelluksilla.[25] Kyse ei ole siis lopulta yksittäisistä teknologioista, vaan niiden konvergenssin mahdollistamista vaikutuksista ja eduista.

Tutkiessa seurauksia tekoälyn konvergenssille erilaisten asekäyttöisten teknologioiden kanssa Future of Life -instituutin Javorsky ja Chaudhry ovatkin ehdottaneet AI+X -lähestymistapaa SIPRIN poikkitieteisen BIO Plus X -projektin tapaan.[26] On nimittäin erittäin kriittistä tiedostaa, että tekoäly ei vahvista vain tavanomaisten aseiden käyttöä sodankäynnissä, vaan se tekee myös joukkotuhoaseiden valmistamisesta helpompaa ja edullisempaa. Erityisen vaarallisia ovat sen tuomat edistysaskeleet synteettisessä biologiassa ja kemiassa. Esimerkiksi eräässä tunnetussa kokeessa vuodelta 2022 tekoälyalgoritmi onnistui kehittämään alle kuudessa tunnissa yli 40 000 molekyyliä, joiden kaikkien arvioitiin olevan luultavasti nykyisiä kemiallisia aseita myrkyllisempiä.[27]

Kun algoritmit alkavat olla itsessään jo niin kyvykkäitä, että ihmisen rooliksi jää vain antaa asejärjestelmälle lupa toimia, autonomisen asejärjestelmän ero (tekoälyohjatusta) voi olla vain yhden komennon puuttuminen. Silloin autonomisten järjestelmien erillinen rajoittaminen ei olisi enää leviämisen esto- tai vientivalvontakysymys, ja lain, johtosäännön tai eettisen koodin noudattaminen jää puhtaasti aseen käyttäjän vastuulle. Tällöin olisi kyse sodankäynnin sääntöjen päivittämisestä, ja viime kädessä valtioiden ja toimijoiden valmiudesta noudattaa niitä tositilanteissa.

Oli loppupäätös voimankäytöstä ihmisellä tai koneella, vaikuttaa asekäyttöisen tekoälyn kilpavarustelusta seuraavan jälleen sama vaikutus kuin minkä tahansa aseteknologisen kilpavarustelun kohdalla: sotilasvoimien tuhopotentiaalin merkittävä kasvu.

SAMUEL TAMMEKANN

Infopaperin koostaja on SaferGloben viestintäkoordinaattori, entinen konsultti ja nykyinen taloushistorian opiskelija, jonka kandidaatintutkielma Helsingin yliopistossa käsitteli tekoälyn, kansallisen turvallisuuden käsitteen ja suurvaltakilpailun vaikutusta Yhdysvaltojen teknologisen vientivalvontapolitiikan käänteeseen 2020-luvun vaihteessa.

[1] Schumann, Anna (2023). Fact Sheet: Autonomous Weapons. (15.11.2023). Center for Arms Control and Non-Proliferation. https://armscontrolcenter.org/fact-sheet-autonomous-weapons/. (luettu 13.5.2024).

[2] [4] [20] [24] Adam, David (2024). Lethal AI weapons are here: how can we control them? Nature. 629(8012), 521–523. DOI: 10.1038/d41586-024-01029-0.

[3] Center for Security and Emerging Technology & Ben Buchanan (2020). The AI Triad and What It Means for National Security Strategy. Center for Security and Emerging Technology. https://cset.georgetown.edu/publication/the-ai-triad-and-what-it-means-for-national-security-strategy/. DOI: 10.51593/20200021.

[5] [12] How Tech Giants Turned Ukraine Into an AI War Lab. (2024). (8.2.2024). TIME. https://time.com/6691662/ai-ukraine-war-palantir/. (luettu 27.4.2024); Abraham, Yuval (2024). ‘Lavender’: The AI machine directing Israel’s bombing spree in Gaza. (3.4.2024). +972 Magazine. https://www.972mag.com/lavender-ai-israeli-army-gaza/. (luettu 15.5.2024).

[6] [8] Hillner, Eric P (2019). The Third Offset Strategy.

[7] Fravel, M. Taylor (2020). China’s “World-Class Military” Ambitions: Origins and Implications. The Washington Quarterly. Routledge, 43(1), 85–99. DOI: 10.1080/0163660X.2020.1735850.

[9] Robertson, Noah (2023). Pentagon unveils ‘Replicator’ drone program to compete with China. (28.8.2023). Defense News. https://www.defensenews.com/pentagon/2023/08/28/pentagon-unveils-replicator-drone-program-to-compete-with-china/. (luettu 15.5.2024).

[10] Losey, Stephen (2024). US Air Force stages dogfights with AI-flown fighter jet. (19.4.2024). Defense News. https://www.defensenews.com/air/2024/04/19/us-air-force-stages-dogfights-with-ai-flown-fighter-jet/. (luettu 15.5.2024).

[11] The Pentagon used Project Maven-developed AI to identify air strike targets. (2024). (27.2.2024). Engadget. https://www.engadget.com/the-pentagon-used-project-maven-developed-ai-to-identify-air-strike-targets-103940709.html. (luettu 15.5.2024).

[13] Hiebert, Kyle (s.a.). Are Lethal Autonomous Weapons Inevitable? It Appears So. Centre for International Governance Innovation. https://www.cigionline.org/articles/are-lethal-autonomous-weapons-inevitable-it-appears-so/. (luettu 15.5.2024).; Autonomiset asejärjestelmät ja digitaalinen dehumanisaatio. (s.a.). Automated Decision Research. https://automatedresearch.org/news/report/autonomiset-asejarjestelmat-ja-digitaalinen-dehumanisaatio/. (luettu 15.5.2024).

[14] Reiff, Ben (2023). ‘A mass assassination factory’: Inside Israel’s calculated bombing of Gaza. (30.11.2023). +972 Magazine. https://www.972mag.com/mass-assassination-factory-israel-calculated-bombing-gaza/. (luettu 15.5.2024).; Abraham, Yuval (2024). ‘Lavender’: The AI machine directing Israel’s bombing spree in Gaza. (3.4.2024). +972 Magazine. https://www.972mag.com/lavender-ai-israeli-army-gaza/. (luettu 15.5.2024).

[15] Kallenborn, Zachary (2020). Swarms of Mass Destruction: The Case for Declaring Armed and Fully Autonomous Drone Swarms as WMD. (28.5.2020). Modern War Institute. https://mwi.westpoint.edu/swarms-mass-destruction-case-declaring-armed-fully-autonomous-drone-swarms-wmd/. (luettu 25.4.2024).

[16] Reuters (2021). US has ”moral imperative” to develop AI weapons, says panel. The Guardian. 26.1.2021. https://www.theguardian.com/science/2021/jan/26/us-has-moral-imperative-to-develop-ai-weapons-says-panel.

[17] Kissinger, Henry A. & Graham Allison (2023). The Path to AI Arms Control. Foreign Affairs. 13.10.2023. https://www.foreignaffairs.com/united-states/henry-kissinger-path-artificial-intelligence-arms-control.

[18] Whang, Cindy (2021). Trade and Emerging Technologies: A Comparative Analysis of the United States and the European Union Dual-Use Export Control Regulations. Security and Human Rights. Brill Nijhoff, 31(1–4), 11–34. DOI: 10.1163/18750230-31010007.

[19] esim. Kristeri, Tomi Tapani (2023). Leveraging Interdependence for Economic Statecraft. Pro gradu -tutkielma. Helsingin yliopisto. https://helda.helsinki.fi/server/api/core/bitstreams/c621b0fc-2a6d-4cba-be7a-a8f6e1c5052c/content.

[21] U.S. 5th Fleet Conducts Unmanned Exercise in the Arabian Gulf. (s.a.). DVIDS. https://www.dvidshub.net/video/902487/us-5th-fleet-conducts-unmanned-exercise-arabian-gulf. (luettu 15.5.2024).

[22] Weaver, John Frank (2020). Everything is not ”terminator”: Exporting our AI, biggering our values. The journal of robotics, artificial intelligence & law. 3(4), 281–287.

[23] Remarks by Commerce Secretary Gina Raimondo at the Meeting of the President’s Export Council Fall 2023 | U.S. Department of Commerce. (2023). https://www.commerce.gov/news/speeches/2023/11/remarks-commerce-secretary-gina-raimondo-meeting-presidents-export-council. (luettu 4.1.2024); Estevez, Alan (2024). Under Secretary of Commerce for Industry and Security Alan F. Estevez Keynote Remarks | Bureau of Industry and Security. https://www.bis.gov/speeches/under-secretary-commerce-industry-and-security-alan-f-estevez-keynote-remarks. (luettu 28.3.2024); Stewart, Jennifer (2024). China’s Tech Goals Force U.S. to Rethink its Export Control Regime: National Defense. National Defense. National Defense Industrial Association, 108(844), 15–16.

[25] Israel Defence Forces’ response to claims about use of ‘Lavender’ AI database in Gaza. (2024). The Guardian. 3.4.2024. https://www.theguardian.com/world/2024/apr/03/israel-defence-forces-response-to-claims-about-use-of-lavender-ai-database-in-gaza.

[26] Javorsky, Emilia & Hamza Chaudhry (2023). Convergence: Artificial intelligence and the new and old weapons of mass destruction. (18.8.2023). Bulletin of the Atomic Scientists. https://thebulletin.org/2023/08/convergence-artificial-intelligence-and-the-new-and-old-weapons-of-mass-destruction/. (luettu 15.5.2024).

[27] Meier, Oliver (2024). The fast and the deadly: When Artificial Intelligence meets Weapons of Mass Destruction. European Leadership Network. 27.6.2024.

https://europeanleadershipnetwork.org/commentary/the-fast-and-the-deadly-when-artificial-intelligence-meets-weapons-of-mass-destruction/.